- 텍스트 축소

- 확대

인텔, ‘핫 칩스 2024’서 AI 데이터 처리 OCI 칩렛 기술 공개

- 송고 2024.08.27 14:40 | 수정 2024.08.27 14:41

- EBN 김채린 기자 (zmf007@ebn.co.kr)

업계 최초 AI 데이터 처리를 위한 완전 통합형 광학 컴퓨트 인터커넥트

OCI 칩렛 및 데이터센터, 클라우드, 네트워크 등 AI 광범위 사용 기술 등

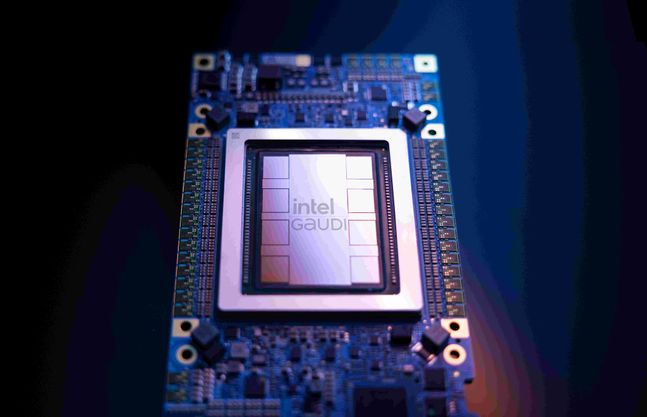

인텔 가우디. ⓒ인텔

인텔이 27일 첨단 반도체 기술을 발표하는 업계 컨퍼런스인 ‘핫 칩스 2024(Hot Chips 2024)’에서 업계 최초 고속 AI 데이터 처리를 위한 완전 통합형 광학 컴퓨트 인터커넥트(OCI) 칩렛 등의 기술을 공개했다.

이날 인텔은 OCI 칩렛과 함께 데이터센터, 클라우드, 네트워크에서 엣지 및 PC에 이르기까지 AI 사용 사례 전반에 걸쳐 폭넓고 깊이 있는 기술을 선보였다. 2025년 상반기 출시 예정인 제온 6 SoC(코드명: 그래나이트 래피즈-D)에 대한 세부 정보도 공개했다.

페레 몬클루스(Pere Monclus) 인텔 네트워크 및 엣지 그룹 CTO는 “인텔은 소비자 및 엔터프라이즈 AI 사용 전반에 걸쳐 가능성을 새로이 정의하는 데 필요한 플랫폼, 시스템 및 기술을 지속적으로 제공하고 있다”며 “AI 워크로드가 심화됨에 따라 인텔은 광범위한 업계 경험을 통해 고객이 혁신, 창의성 및 이상적인 비즈니스 결과를 이끌어내는 데 필요한 것이 무엇인지 이해할 수 있게 됐다”고 말했다.

이어 “더 높은 성능의 실리콘과 더 많은 플랫폼 대역폭이 필수적이지만 인텔은 모든 워크로드마다 고유한 과제가 있다는 사실도 잘 알고 있고 데이터센터용으로 설계된 시스템은 엣지용으로 용도를 변경할 수 없다”며 “컴퓨팅 전반에 걸쳐 시스템 아키텍처에 대한 전문성을 갖춘 인텔은 차세대 AI 혁신을 주도할 수 있는 유리한 위치를 점하고 있다”고 덧붙였다.

행사에서 인텔은 인텔 제온 6 SoC, 루나 레이크 클라이언트 프로세서, 인텔 가우디 3 AI 가속기, OCI 칩렛과 관련된 기술 논문 4건을 발표했다.

인텔 프라빈 모수르(Praveen Mosur) 펠로우 겸 네트워크 및 엣지 실리콘 아키텍트는 인텔 제온 6 시스템 온 칩(SoC) 설계와 불안정한 네트워크 연결, 제한된 공간과 전력 같은 엣지 특유의 문제를 해결할 수 있는 방법에 대한 새로운 정보를 공개했다.

전 세계적으로 9만 건 이상의 엣지 배포를 통해 얻은 정보를 바탕으로 이 SoC는 인텔 역사상 가장 엣지에 최적화된 프로세서가 될 예정이다. 단일 시스템 아키텍처와 통합된 AI 가속 기능을 사용해 엣지 디바이스에서 엣지 노드까지 확장할 수 있어 기업은 데이터 수집부터 추론에 이르기까지 전체 AI 워크플로우를 보다 쉽고 효율적으로 그리고 안전하게 관리할 수 있다. 이를 통해 의사 결정이 개선되고 자동화가 증가하며 고객에게 더 큰 가치를 제공할 수 있다.

인텔 제온 6 SoC는 인텔 제온 6 프로세서의 컴퓨트 칩렛과 인텔 4 공정 기술을 기반으로 설계된 엣지에 최적화된 I/O 칩렛을 결합했다. 이를 통해 SoC는 이전 모델에 비해 성능, 전력 효율 및 트랜지스터 집적도 등이 개선됐다.

로만 카플란(Roman Kaplan) AI 가속기 수석 아키텍트는 막대한 연산 능력을 요구하는 생성형 AI 모델의 학습과 배포와 관련해 발표했다. 단일 노드에서 수천 개의 거대한 노드 클러스터로 시스템이 확장됨에 따라 비용과 전력 문제가 커지게 된다.

인텔 가우디 3 AI 가속기는 효율적인 행렬 곱셈 엔진, 이중 캐시 통합, 광범위한 RoCE(RDMA over Converged Ethernet) 네트워킹 등 다양한 전략을 채택하고 있다. 이를 통해 연산, 메모리 및 네트워킹 아키텍처를 최적화해 이런 문제를 해결한다. 가우디 3 AI 가속기는 AI 데이터센터가 더욱 비용 효율적이고 지속 가능하게 운영될 수 있도록 성능과 전력 효율성을 크게 향상시켜 생성형 AI 워크로드 배포 시 발생하는 확장성 문제를 해결한다.

©(주) EBN 무단전재 및 재배포 금지

![[포토] 롯데百, ‘오호스 X 데상트’ 팝업행사 오픈](https://cdnimage.ebn.co.kr/news/202409/news_1725610061_1636253_c.jpeg)

![[포토] 롯데百 잠실점, 하이엔드 카메라 ‘라이카’ 오픈](https://cdnimage.ebn.co.kr/news/202409/news_1725861584_1636430_c.jpeg)

![[EBN 칼럼] 욕의 서사](https://cdnimage.ebn.co.kr/news/202302/news_1676633363_1567327_c.jpeg)